画像認識システム、だますのは意外に簡単

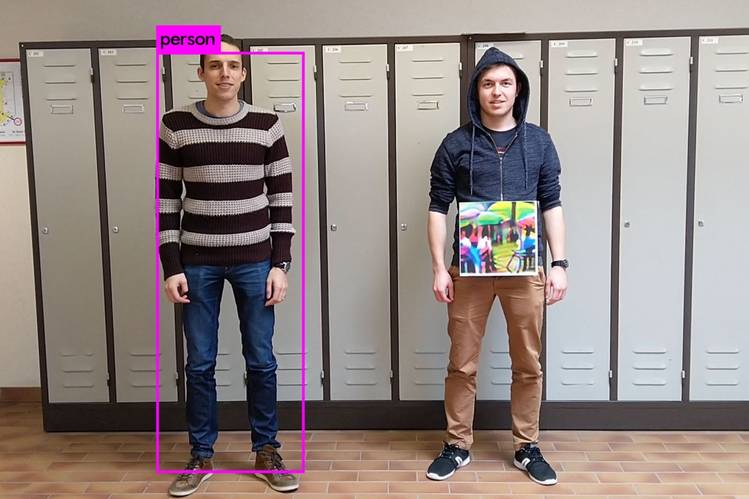

実験によるとカラフルな特製ポスターが前にあるだけで画像分類システムは人物を視認できなくなる Photo: Wiebe Van Ranst

昨年、セキュリティー新興企業のゼロフォックスは、ある著名人のソーシャルメディア(SNS)の偽アカウントのプロフィルが何か変だと気づいた。プロフィル写真の顔一面に雪をふりかけたような白いドットがあった。恐らくコンテンツ・フィルターの目を欺くためであることが疑われた。フェイスブックなどのSNSは有名人の模倣アカウントを見つけ出すためにこうしたシステムを使っている。

同社のエンジニアはこの写真が新手のデジタル・カムフラージュ(時に「敵対的攻撃」と呼ばれる)の一例だろうと考えた。人間の目には普通の写真に見えても、画像認識システムが誤って分類するような方法で修正を加えることだ。

世界中の企業や政府が画像認識技術の導入を急いで進める中、こうした手口はセキュリティー上のリスクを生じる可能性がある。画像認識ソフトはSNSのフィルタリングに利用されるほか、セキュリティーシステムや自動運転車、その他多くの場所で使われており、このような不審な手法は画像認識を利用したシステムが不正の標的になるのをいかに防ぐかという課題を突きつける。

あるテクノロジー企業幹部は、複数のハッカー集団がSNSのコンテンツ・フィルターに「プロービング攻撃」(弱点を見つけるためにスキャンすること)を仕掛けていると話す。標的になったSNS企業はコンテンツのフィルタリングを強化しており、児童ポルノやテロリストの宣伝活動、偽プロフィルといった禁止コンテンツの排除に力を入れている。

フェイスブックの広報担当者は画像認識システムを欺こうとするユーザーがいることを承知していると述べた。社内ではこの技術を「画像および動画コンテンツ・マッチング」と呼んでいる。ユーザーのグループや広告を通じて薬物や銃といった禁止物を販売する目的であることが多く、大抵は初歩的な手法を用いていると広報担当者は指摘。例えば、油で揚げたブロッコリーに見える大麻の画像を使ってフィルターをかいくぐろうとするユーザーがいたが、フェイスブックはこれを正しく警告したという。この担当者は、技術的にもっと高度な画像偽装の例は聞いたことがないとしたうえで、フェイスブックは偽アカウントやスパム(大量の迷惑メッセージ)を大抵はブロックしていると強調し、銃やヌード写真、薬物は禁止コンテンツのごく一部だと指摘した。「それらは全体の数桁分の1にすぎない」

フェイスブックは別のローテク手法による敵対的攻撃への対応に苦慮した。4月にニュージーランドのクライストチャーチで51人の死者を出したモスク銃撃事件で、そのライブ中継動画のコピーが何百万本もフェイスブックにアップロードされたのだ。フェイスブックは「悪人の中核コミュニティー」のせいだと非難した。その手法は初歩的で、動画を若干編集したり、撮り直した新たなコピーを再アップロードしたりしていた。そのためにフェイスブックはコンテンツを識別するために最初の動画につけた電子指紋に頼ることができなかった。さらに、テロリストのコンテンツを警告するフェイスブックの画像認識システムは、三人称視点で撮影された動画で訓練されていたため、この事件のように銃撃犯による一人称視点による動画に苦慮したという。

フェイスブックは数年前から人工知能(AI)の利用を拡大している。同社は3万人のコンテンツ管理スタッフを雇用する一方で、ヘイトスピーチやテロリストの宣伝活動、なりすましアカウントの検出や排除を主としてAIに依存している。投稿されたコンテンツの選別にAIを活用する典型的な分野の1つが画像認識だ。

グーグルは傘下のユーチューブの有害コンテンツをブロックするのに、AIを活用したソフトウエアの役割を徐々に高める計画だという。コンテンツの移動や編集、削除などを担当する1万人のスタッフを雇っているが、ある幹部によると同社はこれを減員する意向だという。「AIが問題を解決する」とこの幹部は述べた。グーグルは画像のデジタル加工を含む敵対的攻撃を同社が受けたことがあるかどうかについてコメントを控えたが、オンラインシステムをこうした攻撃からどう防御するかについて同社が昨年公開した調査報告があると指摘した。

0:00 / 0:00

Police Unlock AI's Potential to Monitor, Surveil and Solve Crimes

ニューオーリンズなどの警察当局は防犯カメラの画像解析にAIベースの分析システムを導入しつつある。WSJのジャイソン・ベリーニ記者が解説する。 Photo: Drew Evans/The Wall Street Journal

その一方で、画像認識システムの敵対的攻撃への脆弱(ぜいじゃく)性を示す科学的根拠は増えている。一例が2018年9月に発表された実験結果だ。クラックコカインをスプーンに入れて加熱するデジタル写真にわずかな修正を加えたところ、人間の目には画像が少しぼやける程度だったが、クラリファイ(ニューヨーク本社)の画像認識システムはこれを「安全」だと判断した。

クラリファイのコンテンツ管理サービスは複数の大手オンラインサービス会社が利用している。同社は実験結果を承知しているとしたが、それを受けて同社の画像認識システムを更新したかどうかについてはコメントしなかった。「われわれは研究結果を共有し、AIモデルの意図せぬ使用に対する防御策を考えるため、AI研究者や当社の顧客がクラリファイと協力することを大いに歓迎する」

「たとえAIやディープラーニング(深層学習)が大幅に進歩しても、深層学習システムは敵対的攻撃によって簡単にだまされることが分かった」。薬物写真の実験を行ったカリフォルニア大学バークレー校のドーン・ソン教授はこう話す。人間の脳に着想を得たコンピューターシステムの一種である深層学習ニューラルネットワークは、大半の画像分類システムを支えている。

さらに、科学者らはオフラインでも画像認識システムをだませることを証明した。ベルギーのルーヴェン・カトリック大学の研究チームは4月、一般的な画像分類システムの目をごまかすため、レコードアルバムのカバー位の大きさのカラフルなポスターを身体の前面に掲げ、監視カメラの前に立つ実験を行った。するとこの特製ポスターのせいで、ソフトウエアにはそれを持つ人物が見えなくなった。

ソン教授率いるチームの2018年の実験では、一時停止の標識に数枚の白黒模様のステッカーを貼った。画像分類システムにそれらが速度制限の標識だと思い込ませるためだった。実験では自動運転車のテストは行っていない。だが実験が成功したことでこの種のソフトウエアのリスクがはっきりしたと研究者は話す。

ニュースレター購読

画像認識システムをだますツールはネット上で容易に見つかる。ドイツのテュービンゲン大学で機械学習を研究するヴィーラント・ブレンデル博士は、画像認識システムに敵対的攻撃を実行するのに使えるプログラミングコードを収集し、ネット上で公開したという。画像認識システムのニューラルネットワークを構築するソフトウエア開発者がそれを利用して脆弱性を試せるようにするためだ。コンテンツ・フィルターを欺くために悪用することも「原則として」可能だと認めつつも、「それが目的ではない。どんな技術もプラスとマイナスの両面に利用できる」と語った。